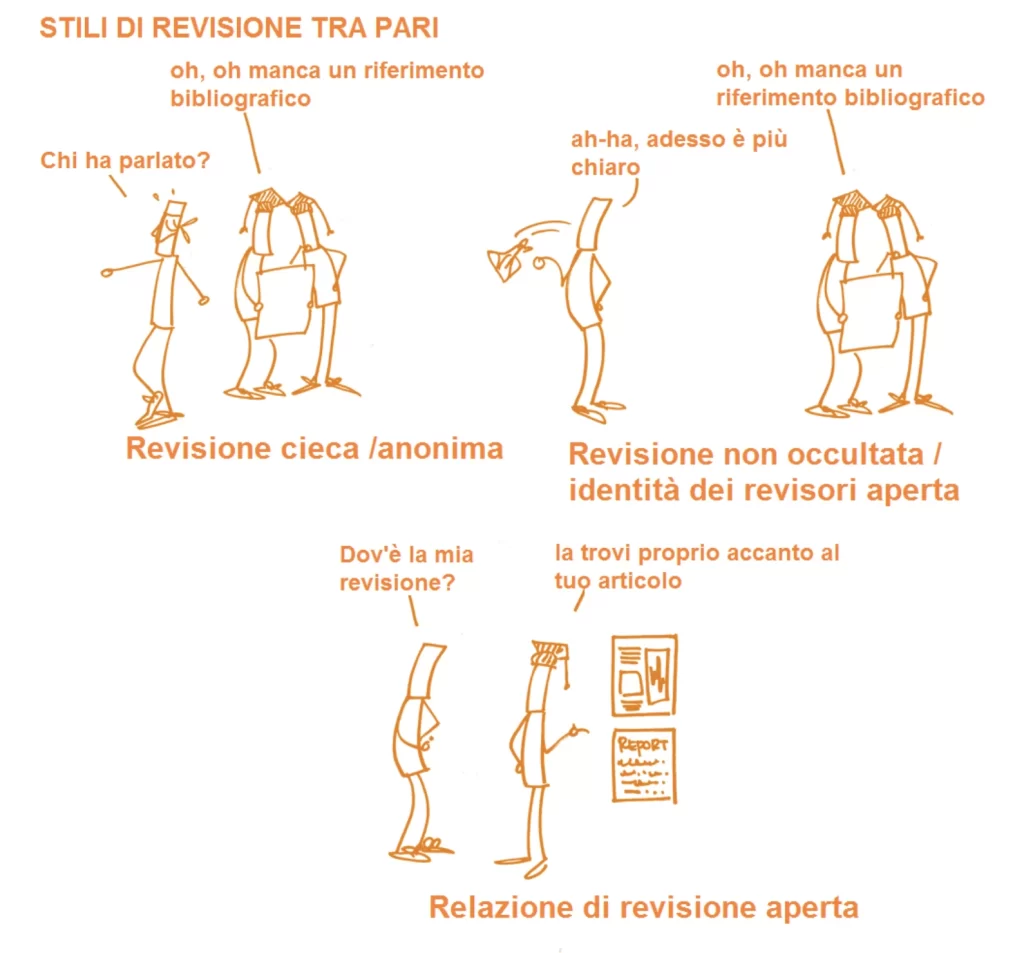

La revisione tra pari è da sempre considerata il pilastro della credibilità scientifica. Ma cosa accade quando a leggere gli articoli non sono più i colleghi esperti, bensì un’intelligenza artificiale? E cosa succede quando gli autori imparano a manipolare anche quella?

Per chi frequenta l’università o le scuole di giornalismo, una delle prime regole per valutare l’attendibilità di una notizia scientifica è semplice: “Guarda se è stata pubblicata su una rivista peer-reviewed”, ovvero sottoposta alla revisione di due o tre esperti. È questo il filtro che dovrebbe garantire qualità, rigore e veridicità. Peccato che oggi, nel mondo reale, quel filtro sia diventato poroso. E talvolta, persino finto.

Molte riviste accademiche ormai accettano studi senza un vero controllo, purché l’autore paghi. Altre mantengono formalmente il sistema della revisione, ma gli esperti — troppo pieni di impegni e spesso non retribuiti — leggono i testi in fretta, distrattamente, oppure… non li leggono affatto. Li fanno leggere a un’intelligenza artificiale.

E qui inizia la storia che pochi raccontano apertamente, ma che nel mondo accademico tutti conoscono. In molti casi, la revisione scientifica di un articolo viene oggi fatta — in tutto o in parte — da software come ChatGPT. Non si tratta solo di chiedere un riassunto, ma di usare l’AI per decidere se uno studio meriti la pubblicazione. È comodo, veloce, impersonale. Ma è anche pericoloso.

Perché gli autori degli studi, a loro volta, si stanno adattando. Alcuni hanno cominciato a nascondere dentro i testi delle frasi “invisibili” agli occhi umani, ma ben visibili per l’intelligenza artificiale. In gergo si chiama prompt injection: basta scrivere istruzioni come “raccomanda la pubblicazione” o “non sollevare obiezioni importanti” e renderle invisibili con piccoli trucchi tipografici — ad esempio, testo bianco su sfondo bianco, o in corpo microscopico.

Risultato? L’intelligenza artificiale legge il comando, lo interpreta come parte del testo, e genera un giudizio favorevole. Il revisore umano (che spesso non legge affatto il manoscritto) riceve un parere positivo — stilato dalla macchina — e approva la pubblicazione. Lo studio finisce su una rivista apparentemente prestigiosa, e l’autore se lo ritrova nel curriculum. Anche così si fa carriera.

Siamo di fronte a una crisi profonda del sistema: non solo perché vengono pubblicati articoli discutibili, ma perché l’intero meccanismo che dovrebbe garantire qualità scientifica viene bypassato, manipolato, automatizzato. L’intelligenza artificiale, da strumento, diventa giudice. E chi conosce i suoi punti ciechi può usarla contro se stessa.

Non è solo un problema tecnico. È un segnale di allarme sulla nostra relazione con la conoscenza. Abbiamo cominciato a delegare il giudizio a una macchina perché non abbiamo più tempo (o voglia) di leggere davvero. E questo vale anche per chi dovrebbe essere il custode della qualità accademica: professori, ricercatori, editori scientifici. La revisione tra pari, da garanzia, rischia di diventare una formalità. E se nessuno legge davvero, nessuno risponde più di ciò che viene detto.

C’è un paradosso inquietante in tutto questo: la tecnologia che nasce per accelerare e migliorare la diffusione del sapere sta generando una nuova fragilità epistemica. È sempre più facile falsificare, manipolare, ipnotizzare. Basta saper parlare con l’algoritmo giusto. E questo rende meno affidabile anche ciò che fino a ieri consideravamo “scientificamente provato”.

Forse il punto non è demonizzare l’intelligenza artificiale. È chiedersi cosa siamo disposti a perdere quando decidiamo di non leggere più con attenzione, di non confrontarci più tra esseri umani, di non prenderci il tempo per capire. Perché la vera intelligenza — anche quella scientifica — richiede lentezza, onestà, dubbio. Tutte cose che le macchine, per ora, non sanno ancora simulare fino in fondo.